La Unión Europea (UE) se toma muy en serio, más que otros estados y administraciones públicas, la protección de los derechos de sus ciudadanos. Así, ha entrado en vigor el nuevo Reglamento de Inteligencia Artificial, la AI Act. En virtud de su artículo 5 se recogen sistemas de IA que no se permiten porque suponen un riesgo inaceptable y potencialmente dañino para los ciudadanos.

El reglamento establece cuatro niveles de sistemas de IA según su riesgo para los derechos fundamentales: Riesgo Inaceptable, Alto Riesgo, Riesgo Limitado y Riesgo Mínimo/Nulo. Los catalogados como riesgo inaceptable están completamente prohibidos.

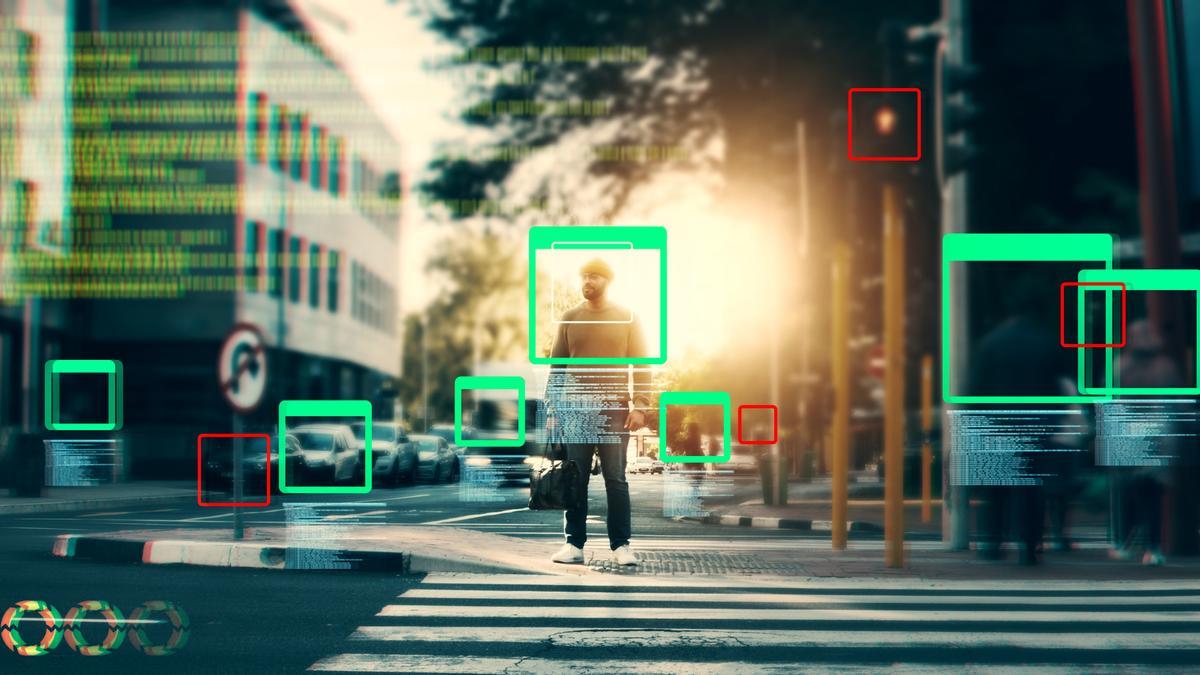

El reconocimiento facial aleatorio en espacios públicos supone una intromisión grave en la privacidad de los ciudadanos.

Tipos de IA prohibidos

Manipulación dañina y explotación de las vulnerabilidades

Prohíbe sistemas de inteligencia artificial que manipulan a personas mediante técnicas subliminales, engañosas o diseñadas para explotar vulnerabilidades por edad, discapacidad o condición socioeconómica.

Ejemplos de estas prácticas son la publicidad subliminal con IA, la manipulación emocional, las plataformas de juego adictivo, los chatbots engañosos y los sistemas que explotan a grupos vulnerables.

Social scoring

Prohíbe la clasificación de personas en base a su comportamiento social o características personales, especialmente si se usa información de diferentes contextos no relacionados o se impone un trato injustificado o desproporcionado. Algunos ejemplos de esta prohibición son los sistemas de crédito social gubernamental, el puntaje de confiabilidad en el trabajo, el control de beneficios sociales o la evaluación de inmigrantes.

Predicción de delitos individuales

Prohíbe el uso de IA para predecir delitos basándose solo en los rasgos físicos o de personalidad de un individuo.

Dentro de esta prohibición entran los sistemas de predicción de criminalidad basados en la raza, nacionalidad, lugar de residencia o nivel educativo; de evaluación del riesgo de reincidencia sin hechos objetivos o la preselección de sospechosos.

La excepción es su utilización para ayudar a la Policía si se basa en hechos verificables relacionados con algún tipo de actividad criminal previa.

Extracción masiva de imágenes faciales

La prohibición de recolectar imágenes faciales de la web o de sistemas de videovigilancia para bases de datos de reconocimiento facial. Busca proteger la privacidad y evitar abusos en vigilancia masiva.

Los sistemas rechazados son el scraping de datos biométricos y el uso de la videovigilancia para su recolección indiscriminada.

Reconocimiento de emociones

Prohíbe el uso de IA que deduzca emociones en centros de trabajo y educativos, salvo por razones médicas o de seguridad. Considera que esta tecnología puede ser invasiva y propensa a errores. Algunos ejemplos de estos sistemas son la detección de emociones para evaluar su implicación, motivación o interés.

Categorización biométrica de características sensibles

Prohíbe sistemas de inteligencia artificial que deduzcan rasgos sensibles, como raza, religión, opiniones políticas u orientación sexual, por ejemplo basándose en su rostro o comportamiento digital, o el filtrado de personas en aeropuertos en base en características biométricas sensibles.

Una excepción permitida es el uso de etiquetado de bases de datos biométricas adquiridas legalmente para aplicaciones de seguridad.

Identificación biométrica remota

Prohíbe el reconocimiento biométrico en tiempo real en espacios públicos para la aplicación de la ley. Ejemplos de esta prohibición son las cámaras de vigilancia en espacios públicos con reconocimiento facial en vivo o la identificación masiva en eventos deportivos o manifestaciones.

Se excluye de esta prohibición la búsqueda de víctimas de delitos graves o personas desaparecidas, la prevención de ataques terroristas inminentes o la localización de sospechosos de delitos graves, con autorización previa.

¿Qué pasa con quien no cumpla?

Desde el momento de la aplicación de este reglamento, e independientemente de si ya estaba introducido en el mercado o no, cualquier sistema de IA que realice estas prácticas prohibidas estará sujeto a sanciones severas. Según el anteproyecto, las multas en España podrán ser de hasta 35 millones de euros o hasta del 7% del volumen de negocios anual de la empresa infractora.

Además, cada estado debe designar autoridades de vigilancia del mercado antes del 2 de agosto de 2025. En España será la Agencia Española de Supervisión de Inteligencia Artificial (AESIA) la encargada de garantizar el uso ético y seguro de la inteligencia artificial.